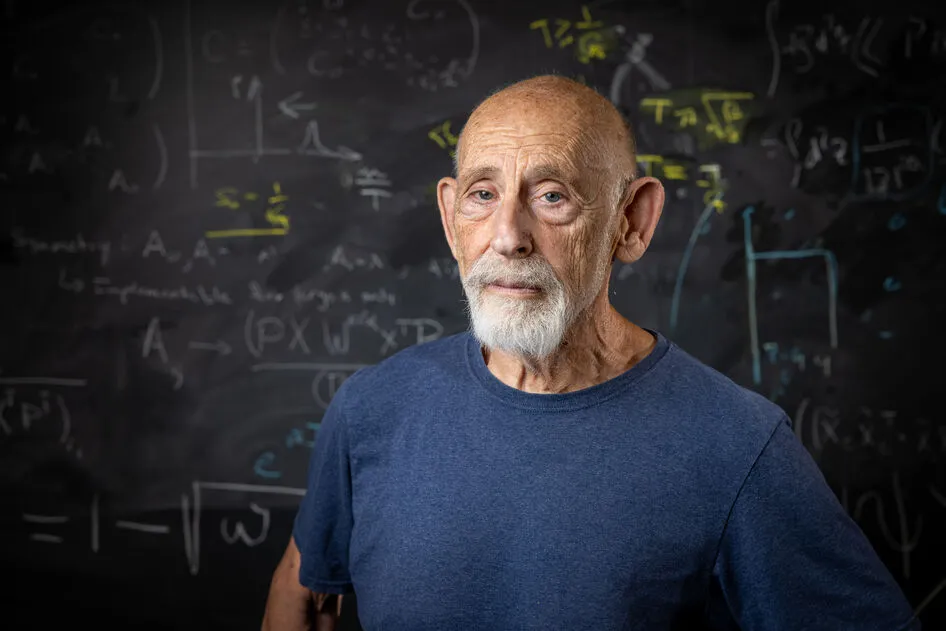

Intervista a Michela Milano, professoressa presso l’Università di Bologna, dove dirige il Centro Interdipartimentale Alma Mater Research Institute on Human-Centered Artificial Intelligence (ALMA AI), e tra le figure di riferimento nelle principali iniziative strategiche sull’AI a livello nazionale ed europeo

Come nasce ALMA AI e con quali obiettivi?

ALMA AI è un centro interdipartimentale che coinvolge 28 dipartimenti dell’Università di Bologna e oltre 520 tra ricercatori, ricercatrici e docenti, a cui si aggiungono tantissimi dottorandi e dottorande attivi in questo ambito. È nato nel 2020, con lo scopo di costruire una massa critica capace di lavorare a 360° su tematiche relative all’intelligenza artificiale. Nello specifico, ci ponevamo la questione di trattare l’intelligenza artificiale, in un ateneo generalista come il nostro, non soltanto in termini di sviluppi tecnologici e scientifici, ma anche nella sua fortissima connessione con le applicazioni in medicina, agricoltura, meccatronica, aerospazio, e con le discipline umanistiche – dalle scienze sociali all’economia, dalla giurisprudenza all’etica, alla psicologia. Volevamo da un lato analizzare l’impatto di queste tecnologie sulla società, sulla legge, sul mercato, e dall’altro contribuire a sviluppare modelli di AI che tenessero conto delle dinamiche e della complessità umane. Da questa commistione di saperi è nato un centro unico nel suo genere, popolato non soltanto da ingegneri, informatici, fisici e matematici, ma da studiose e studiosi con competenze molto variegate. Naturalmente, la prima esigenza è stata quella di favorire la conoscenza reciproca, poiché in un ateneo che conta quasi 100.000 studenti e migliaia di docenti è difficile sapere cosa facciano gli altri. Da questo processo sono nate collaborazioni straordinarie, che hanno reso particolarmente efficace la nostra partecipazione ai bandi europei su Horizon Europe in progetti in cui era richiesta una forte componente SSH (Social Sciences and Humanities), con un tasso di accettazione pari al 67%.

In che modo ALMA AI dialoga con le iniziative europee dedicate all’intelligenza artificiale?

Siamo parte attiva di tutte le più grandi iniziative europee, tra cui vale la pena citare l’AI-on-Demand Platform. Questo esperimento della Commissione Europea, anche noto come One-stop shop for AI solutions in Europe, consiste in una piattaforma che aggrega non solo tutti gli strumenti di intelligenza artificiale sviluppati in Europa – o anche altrove, purché rispettino le direttive europee sull’AI, il cosiddetto AI Act –, ma anche i risultati, le ricercatrici e i ricercatori attivi nel settore, come un vero e proprio network. Non è il solo, chiaramente. ALMA AI ha infatti preso parte a diverse reti di eccellenza europee, dedicate, per esempio, all’interfaccia essere umano-AI (Human-AI Interface) e all’affidabilità dell’AI (Trustworthy AI). Anche sul piano nazionale siamo parte di un partenariato esteso molto importante, la Fondazione FAIR – Future Artificial Intelligence Research, finanziata dal PNRR con115 milioni e gestita dal CNR Consiglio Nazionale delle Ricerche. Il progetto si basa sul modello hub & spoke, che promuove la collaborazione tra un centro di coordinamento e diversi atenei partner. ALMA AI è capofila dello Spoke 8, dedicato alla Pervasive AI, cioè allo studio della pervasività dell’intelligenza artificiale: un tema che riflette perfettamente l’approccio multidisciplinare che caratterizza il nostro centro.

Quali attività portate avanti all’interno dello Spoke 8 di FAIR?

L’AI si sta inserendo in qualunque ambito della nostra società, negli uffici, nelle scuole, negli ospedali, nelle città: allo Spoke 8 siamo partiti da questa constatazione, che pone una serie di sfide tecnologiche e applicative. Dal punto di vista tecnologico, lavoriamo su tre grandi fronti: la gestione di dati eterogenei, provenienti sia dalle infrastrutture sia da dinamiche umane e sociali, meno controllabili; la gestione di decisioni su scale spaziali e temporali diverse, dal tempo reale fino alla pianificazione strategica di lungo periodo; la gestione di infrastrutture di calcolo diverse, dal modello edge (in cui i dati vengono elaborati vicino a dove sono generati), al cloud, ai supercalcolatori. Questa eterogeneità di dati, scale e infrastrutture ha dato origine a una serie di linee di ricerca. La prima linea gestisce tutta la filiera dei dati, dai sensori fino alla pianificazione strategica. Una linea riguarda l’affidabilità di questi sistemi, soprattutto dei sistemi fondazionali enormi, che a volte producono risultati un po’ oscuri, che sono ragionevoli, ma fattualmente sbagliati. La terza linea riguarda la gestione della multimodalità, cioè l’integrazione di dati testuali, visivi, numerici e temporali. Sul piano applicativo, invece, lo Spoke 8 affronta le principali sfide sociali e culturali dell’intelligenza artificiale, articolate in diversi work-package. Uno è dedicato alle sfide sociali, come l’accettazione dei sistemi di AI in contesti safety critical (nella sanità, per esempio); un altro si occupa di educazione e formazione, intesa sia come AI a supporto della didattica, della valutazione, del recruiting di studenti, sia come didattica di AI in senso ampio, per l’up-skilling e il re-skilling di figure professionali già inserite in azienda che si trovano a interagire con questi nuovi sistemi e non ne conoscono opportunità e rischi; un work-package esplora poi il rapporto tra AI e creatività, studiando come la co-creazione tra umano e AI possa aprire nuovi percorsi artistici; e un work-package si concentra sulle implicazioni giuridiche: da un lato su come usare l’intelligenza artificiale per supportare le attività normative e di conformità, dall’altro, su come regolamentare l’AI. In questo ambito abbiamo contribuito anche alla definizione dell’AI Act europeo, e al momento stiamo gestendo il progetto EUSAIR, molto importante, sulle sandbox normative per l’AI, degli ambienti di sperimentazione sicura voluti dall’AI Office della Commissione Europea. Questi ambienti nascono per testare, eventualmente stressare (con attacchi informatici, per esempio) e convalidare i sistemi di AI prima della loro immissione sul mercato o della loro messa in servizio. Ma tornando allo Spoke 8, tutte le attività elencate sono coadiuvate da un work-package più sperimentale, gestito dall’INFN, che ci aiuta a tradurre la ricerca in use-case concreti. Ovviamente, trattandosi di soluzioni di intelligenza artificiale a stretto contatto con le persone, questi use-case vengono costruiti con grandi attenzioni, con modelli equi, inclusivi, giusti, spiegabili, robusti, sicuri e rispettosi della privacy.

Come si costruiscono dei modelli così complessi?

Facciamo un esempio pratico. Qualche anno fa abbiamo collaborato con la Regione Emilia-Romagna, nell’ambito del progetto e-Policy, per progettare incentivi all’uso delle energie rinnovabili, in particolare per l’installazione di pannelli fotovoltaici. Il nostro compito era stimare il tasso di adozione di queste soluzioni a fronte di meccanismi incentivanti. Per ottenere previsioni attendibili abbiamo integrato a un modello di AI classico (che si limitava a correlare la disponibilità economica con la propensione all’adozione), i dati risultanti da diversi studi sociologici. Stando a questi studi, dietro la decisione di adottare una nuova tecnologia ci sono barriere o spinte che non hanno nulla a che fare con aspetti economici. Un potenziale utente, per esempio, può essere influenzato dal comportamento di un vicino che ha già installato i pannelli, dal desiderio di ridurre il proprio impatto ambientale o dall’idea di diventare energeticamente indipendente. Al contrario, può essere frenato dalla sfiducia negli incentivi, dal timore di burocrazia o semplicemente dal disagio di avere i tecnici in casa per l’installazione. Non ci si immagina di dover prendere in considerazione questi aspetti umani e sociali nella progettazione di incentivi, eppure quando li abbiamo inseriti nei nostri simulatori, abbiamo ottenuto previsioni estremamente accurate.

Che cosa succede quando i dati su cui si costruiscono i modelli sono polarizzati o riproducono stereotipi?

Si interviene in due modi: facendo dataset augmentation – cioè ampliando artificialmente il dataset con nuove varianti dei dati esistenti – o costruendo algoritmi che pur partendo da dati polarizzati generano modelli che non lo sono più. Abbiamo adottato il primo approccio, la dataset augmentation, in una collaborazione con la dermatologia pediatrica del Policlinico Sant’Orsola, nell’ambito del progetto AEQUITAS: avevamo sviluppato per loro un sistema di riconoscimento delle lesioni cutanee che raggiungeva un’accuratezza del 95% sulle pelli chiare, ma restava sotto il 50% su quelle scure. Questo perché il dataset di partenza era composto quasi esclusivamente da immagini di pelle chiara. Utilizzando quindi l’AI generativa, abbiamo creato immagini di lesioni su diverse tonalità di pelle, e riaddestrato il sistema con questi nuovi dati. Il risultato è stato un modello con prestazioni praticamente equivalenti su tutte le carnagioni. Quanto invece al secondo approccio, esso agisce direttamente sul modello, introducendo layer (livelli) o vincoli che impongono condizioni di equità. In pratica, il modello viene “guidato” a non generare output distorti rispetto a certi attributi sensibili – come genere, età o etnia – anche se i dati di partenza contengono bias. In questo modo, pur partendo da informazioni sbilanciate, il sistema riesce a produrre risultati più rappresentativi.

In quali direzioni l’Italia può guidare l’innovazione nell’AI valorizzando le proprie specificità?

Sicuramente l’Italia, così come tutti i Paesi appartenenti all’Unione Europea, ha l’AI Act da prendere in considerazione. In Europa alcuni usi dell’intelligenza artificiale sono vietati, ed è un bene che lo siano. La sfida adesso è riuscire a tradurre le direttive giuridiche in requisiti tecnici, un compito difficilissimo e ancora tutto da svolgere. Come con il GDPR, che è stato tanto vessato e che è ormai adottato ovunque, inclusi gli Stati Uniti, abbiamo nella nuova regolamentazione un’opportunità. È interessante poi approfondire la parte relativa all’edge AI – l’implementazione di algoritmi e modelli AI direttamente su dispositivi edge locali – su cui l’Italia è veramente molto forte. Per implementare questi modelli su dispositivi con risorse di calcolo e memoria ridottissime, si adottano tecniche di distillazione e compressione, che vanno a schiacciare i modelli. Un modello piccolo presenta molti vantaggi: è più sostenibile dal punto di vista energetico, più flessibile, cioè più facilmente personalizzabile, più facilmente integrabile con altri sistemi e più efficiente nei tempi di risposta. Ad ALMA AI stiamo già spingendo nella direzione della miniaturizzazione dei modelli, a prescindere dall’edge, perché è un approccio che si adatta bene anche al nostro tessuto industriale, fatto di piccole e medie imprese. Non ha senso per noi inseguire i modelli statunitensi o cinesi in voga, sempre più grandi e onniscienti. Se domani mattina tutte le aziende europee, piccole, medie, grandi, start-up decidessero di usare modelli di questo tipo per tutti i loro business – dall’amministrazione all’ottimizzazione della produzione, alla manutenzione – non avremmo energia a sufficienza per farli girare. Senza contare che in Italia le aziende spesso non conoscono le potenzialità dell’AI. Bisogna allora puntare sulla semplificazione e sulla specializzazione dei modelli, utilizzare i modelli grandi come “insegnanti” per costruire modelli piccoli, capaci di eseguire una specifica applicazione industriale. Un’azienda che scelga, per esempio, un modello capace di fare manutenzione predittiva, non ha bisogno che questo sappia tutto di storia, di musica, di arte. L’idea è quella di buttar via ciò che nel contesto specifico non serve, accompagnando così anche le aziende nell’utilizzo. E ultimo, ma non meno importante, l’Italia dovrebbe dirigersi verso la traslazione in requisiti tecnici non solo di normative giuridiche, ma anche di principi etici, come l’equità, stabilendo innanzitutto cosa intende con “equità”. Ci sono moltissime metriche diverse applicabili ai sistemi di AI, perciò è importante definirle, essere in grado di misurarle e implementare sistemi che rispondano a queste metriche, valutando sin da subito dei metodi per mitigarli nel caso in cui le loro performance non siano soddisfacenti. Queste, secondo me, sono le direzioni verso cui convogliare i nostri sforzi.

BIO

Michela Milano è professoressa presso l’Università di Bologna dove dirige il Centro Interdipartimentale Alma Mater Research Institute on Human-Centered Artificial Intelligence (ALMA AI). Dirige anche il centro Digital Societies di FBK Fondazione Bruno Kessler, ed è stata vicepresidente della European Association on Artificial Intelligence e consigliere esecutivo della Association for the Advancements of Artificial Intelligence. Ha partecipato al gruppo di esperti che hanno redatto la strategia nazionale sull’AI e fa parte della delegazione italiana nel Program Committee di Horizon Europe per il Cluster 4. È autrice di oltre 180 lavori per riviste e conferenze internazionali, ha vinto numerosi premi e progetti, ed è coinvolta nelle principali iniziative strategiche sull’AI a livello nazionale ed europeo.