IA e fisica delle particelle

Nella ricerca fondamentale in fisica, una delle sfide più importanti riguarda oggi la gestione e l’analisi dei grandi volumi di dati prodotti dalle collaborazioni scientifiche internazionali. Gli algoritmi di machine learning sono ormai strumenti fondamentali per individuare segnali significativi all’interno dei dati sperimentali, accelerando in modo sostanziale il processo di analisi rispetto agli approcci tradizionali. Queste tecniche trovano applicazione anche nel riconoscimento delle particelle prodotte nelle collisioni ad altissima energia, offrendo prestazioni più efficienti rispetto ai metodi convenzionali. Inoltre, l’apprendimento automatico consente di sviluppare e implementare modelli fisici sempre più complessi, rendendo le simulazioni numeriche più rapide, dettagliate e realistiche. Alla scienza dell’Intelligenza artificiale è dedicato anche l’ultimo numero di Asimmetrie, la rivista di informazione e divulgazione dell’INFN con articoli di approfondimento e infografiche.

Anche la storia dell’intelligenza artificiale affonda le sue radici nella fisica. Le basi teoriche dell’IA trovano, infatti, fondamento nella fisica statistica e nella teoria dei sistemi complessi. I primi modelli concettuali risalgono al secondo dopoguerra, ma è solo verso la fine del Novecento che le prime applicazioni pratiche diventano realmente possibili, grazie ai progressi dell’informatica e alla crescente disponibilità di potenza di calcolo.

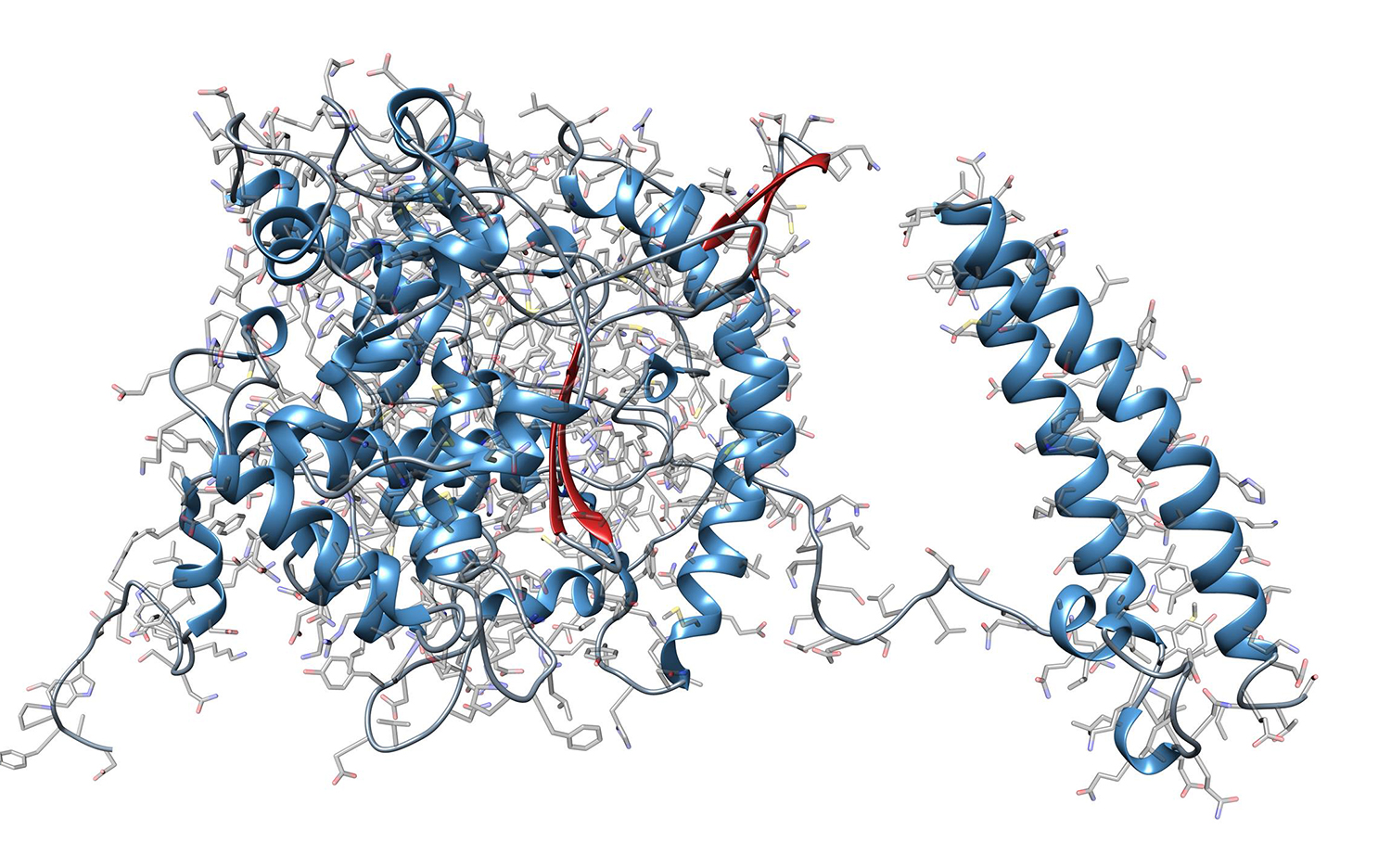

Già dagli anni ’80, i fisici hanno impiegato reti neurali e altri algoritmi per analizzare dati sperimentali. Tecniche di questo tipo hanno avuto, ad esempio, un ruolo importante nella determinazione degli elementi della matrice Cabibbo-Kobayashi-Maskawa, che spiega la simmetria tra materia e antimateria nei quark (premio Nobel per la fisica del 2008 a Makoto Kobayashi e Toshihide Maskawa) e nella scoperta del bosone di Higgs, che spiega l’origine della massa delle particelle elementari (premio Nobel per la fisica del 2013 a Peter Higgs e François Englert).

Al CERN di Ginevra e al Fermilab (USA), alla fine degli anni ’80, gli scienziati iniziano a usare il machine learning per analizzare i dati e riconoscere le tracce delle particelle pesanti. In un articolo del 1992 si discute dell’impiego di reti neurali per l’identificazione dei quark b e c (due dei sei tipi “sapori” di quark conosciuti nel Modello Standard ) nei dati prodotti dall’esperimento Delphi all’acceleratore LEP del CERN. Pur con le limitazioni imposte dalla tecnologia di quegli anni, l’IA mostrò di essere uno strumento concorrenziale con gli altri approcci e si guadagnò un posto tra le tecniche per l’analisi dei dati utilizzate nella fisica delle particelle.