n.8 | Novembre 2025

n.8 | Novembre 2025

Coerente, specializzata, etica: la prossima AI italiana

Prompting the real. Artists-AI Co-creation, ovvero Stimolare il reale. La co-creazione di artisti e intelligenza artificiale (AI): è questo il titolo della mostra che il 15 e 16 novembre accenderà Palazzo Poggi a Bologna. Un’occasione preziosa per ribaltare un gesto che è ormai parte del quotidiano: la formulazione di un prompt, un comando che orienta la generazione da parte di un’AI. Che cosa succede se, al contrario, è l’AI a dare un input all’artista all’interno di un processo creativo? Apre nuovi scenari? O riproduce meccanismi di cui vorremmo liberarci? La mostra indaga il potenziale e i limiti di questa co-creazione, una tensione tra possibilità e rischio che attraversa tutti gli ambiti dell’intelligenza artificiale – dalla creatività all’economia, dalla pianificazione urbana alla ricerca scientifica. In tutti questi contesti l’AI si scontra con dinamiche umane e sociali imprevedibili, sfumature di comportamento difficili da cogliere, livelli decisionali complessi e stratificati, e se i modelli che la guidano non sono costruiti in modo equo, inclusivo e sicuro, difficilmente riuscirà a produrre risultati all’altezza delle aspettative. Della sua pervasività, dell’elaborazione di output non stereotipati e di modelli etici e sostenibili abbiamo parlato con Michela Milano, direttrice del centro che ha ideato Prompting the real, l’Alma Mater Research Institute on Human-Centered Artificial Intelligence (ALMA AI), in collaborazione con il Centro Nazionale di Ricerca in HPC, Big Data and Quantum Computing (ICSC) e l’Istituto Nazionale di Fisica Nucleare (INFN), e con il patrocinio della Fondazione FAIR – Future Artificial Intelligence Research.

Michela Milano è professoressa presso l’Università di Bologna dove dirige il Centro Interdipartimentale Alma Mater Research Institute on Human-Centered Artificial Intelligence (ALMA AI). Dirige anche il centro Digital Societies di FBK Fondazione Bruno Kessler, ed è stata vicepresidente della European Association on Artificial Intelligence e consigliere esecutivo della Association for the Advancements of Artificial Intelligence. Ha partecipato al gruppo di esperti che hanno redatto la strategia nazionale sull’AI e fa parte della delegazione italiana nel Program Committee di Horizon Europe per il Cluster 4. È autrice di oltre 180 lavori per riviste e conferenze internazionali, ha vinto numerosi premi e progetti, ed è coinvolta nelle principali iniziative strategiche sull’AI a livello nazionale ed europeo.

Michela Milano

Intervista a Michela Milano, professoressa presso l’Università di Bologna dove dirige il Centro Interdipartimentale Alma Mater Research Institute on Human-Centered Artificial Intelligence (ALMA AI)

Come nasce ALMA AI e con quali obiettivi?

ALMA AI è un centro interdipartimentale che coinvolge 28 dipartimenti dell’Università di Bologna e oltre 520 tra ricercatori, ricercatrici e docenti, a cui si aggiungono tantissimi dottorandi e dottorande attivi in questo ambito. È nato nel 2020, con lo scopo di costruire una massa critica capace di lavorare a 360° su tematiche relative all’intelligenza artificiale. Nello specifico, ci ponevamo la questione di trattare l’intelligenza artificiale, in un ateneo generalista come il nostro, non soltanto in termini di sviluppi tecnologici e scientifici, ma anche nella sua fortissima connessione con le applicazioni in medicina, agricoltura, meccatronica, aerospazio, e con le discipline umanistiche – dalle scienze sociali all’economia, dalla giurisprudenza all’etica, alla psicologia. Volevamo da un lato analizzare l’impatto di queste tecnologie sulla società, sulla legge, sul mercato, e dall’altro contribuire a sviluppare modelli di AI che tenessero conto delle dinamiche e della complessità umane.

Leggi l'intervista Leggi l'intervista- 26/09-10/12

- 6-11 novembre

- 21-23 novembre

- 23 novembreMalnisio (PN)Malnisio Science FestivalMalnisio Science Festival

Quantum computing: si rinnova la collaborazione tra INFN e il laboratorio statunitense SQMS

LIGO, Virgo e KAGRA osservano per la prima volta buchi neri di ‘seconda generazione’

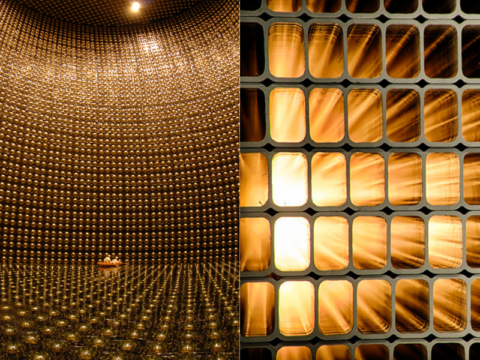

Neutrini: NOvA e T2K riducono l’incertezza sui parametri di oscillazione

Nuovi risultati sul neutrino di Majorana grazie a un algoritmo “anti-rumore”

Particle Chronicle © 2025 INFN

REDAZIONE

Coordinamento Martina Galli;

Progetto e contenuti Martina Bologna, Cecilia Collà Ruvolo, Eleonora Cossi,

Francesca Mazzotta, Antonella Varaschin;

Design e coordinamento tecnico Francesca Cuicchio; ICT service SSNN INFN